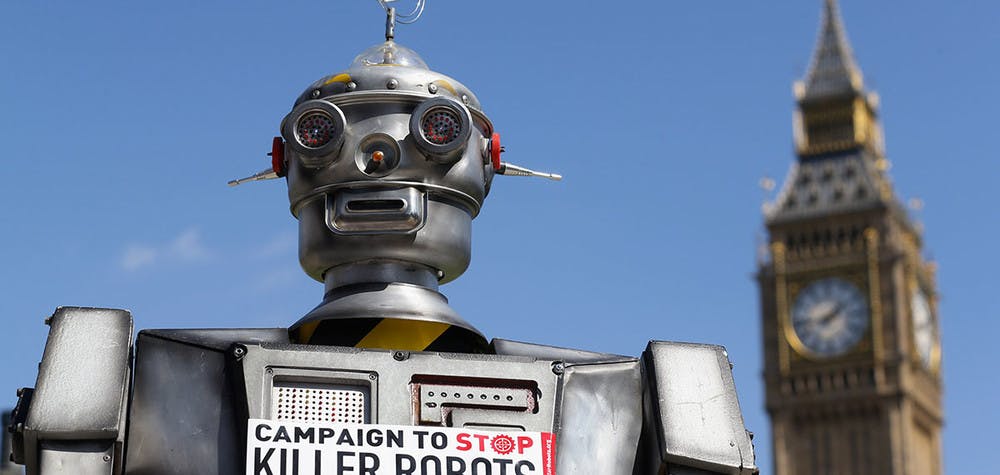

Les gouvernements réunis à Genève en cette fin d’année se sont engagés en faveur d’un processus mondial de négociation et d’interdiction des « robots tueurs ». 10 raisons qui doivent nous pousser à prendre conscience de cette menace bien réelle.

1. Les robots tueurs ne sont plus de la science-fiction.

Une fois activés, les robots tueurs peuvent sélectionner, attaquer et tuer ou blesser des cibles humaines, sans intervention de l’homme. Appartenant jadis au domaine de la science-fiction dystopique, ces armes – aussi appelées « systèmes d'armes entièrement autonomes » (AWS) – vont bientôt devenir réalité.

De nombreux précurseurs de cette technologie existent déjà. Le drone ShadowHawk développé par Vanguard Defense Industries, aux États-Unis, par exemple, peut être équipé d'un lance-grenades, d'un fusil avec désignateur laser, ou d'armes à létalité réduite comme un Taser ou un lanceur de « sacs à fèves ». En 2011, le bureau du shérif du comté de Montgomery, au Texas, a acheté un ShadowHawk non armé en utilisant une subvention du Département de la sécurité du territoire. En août 2015, le Dakota du Nord est devenu le 1er État américain à légaliser l'utilisation de drones qui peuvent être dirigés à distance pour immobiliser des personnes en leur administrant des décharges électriques à haute tension.

2. Ils peuvent être ouvertement utilisés pour réprimer par des gouvernements n'ayant pas à rendre de comptes.

Certains gouvernements affirment que les robots tueurs réduiraient les risques inhérents au déploiement de soldats sur les champs de bataille, ou de policiers lors d'opérations de maintien de l'ordre. Les gouvernements pourraient alors plus aisément s'engager dans des conflits armés et utiliser la force pour, par exemple, maintenir l'ordre lors de manifestations. La sécurité des soldats et des policiers serait peut-être renforcée, mais cela risquerait d'engendrer une hausse des affrontements et des recours à la force et, par conséquent, des risques pour les civils.

Les partisans des robots tueurs avancent également que leur absence d'émotion éliminerait les caractéristiques humaines négatives telles que la peur, la vengeance, la rage et l'erreur humaine. Or, les émotions peuvent être des garanties face à la possibilité de tuer ou blesser des civils, et les robots pourraient facilement être programmés pour mener des attaques arbitraires et sans discrimination contre des êtres humains, même à grande échelle. Ils seraient incapables de refuser un ordre, ce qui sauve parfois des vies. Lors des manifestations de masse en Égypte, en janvier, l'armée a refusé de tirer sur les manifestants, un acte qui exigeait la compassion inhérente à l'homme et le respect de l'état de droit.

3. Ils ne sont pas conformes aux normes internationales relatives aux droits humains et au maintien de l'ordre.

Les normes internationales relatives au maintien de l'ordre interdisent l’usage d'armes à feu, sauf en cas de risque imminent de mort ou de blessure grave, et précisent que la force ne doit être utilisée que dans les limites du minimum nécessaire. Il est très difficile d'imaginer une machine se substituer au jugement humain en cas de risque immédiat et direct d'homicide, et utiliser ensuite la force appropriée dans les limites du minimum nécessaire pour stopper l'attaque. Pourtant, un tel jugement est d’une importance cruciale lorsqu’il s’agit de déterminer s’il faut utiliser une arme. Dans la plupart des situations, les policiers sont tenus par les normes de l'ONU de recourir en premier lieu à des moyens non violents, comme la persuasion, la négociation et le désamorçage, avant de recourir à toute forme de force.

Maintenir l'ordre ne se résume pas au simple usage de la force : cela requiert des qualités humaines que sont l'empathie et la négation, et la capacité d'évaluer et de réagir à des situations souvent dynamiques et imprévisibles. On ne saurait réduire ces compétences à de simples algorithmes. Elles supposent d'évaluer des situations en perpétuelle évolution et de déterminer comment protéger légalement le droit à la vie et à l'intégrité physique, ce que des machines sont tout simplement incapables de faire. Lorsque des responsables de l'application des lois décident d'employer la force minimale dans des situations précises, ils font appel à leur jugement humain sur la nature de la menace et le contrôle efficace de toute arme. Pour faire simple, ces décisions dans des situations de vie ou de mort ne sauraient être déléguées à des machines.

4. Ils ne respectent pas les lois de la guerre.

La distinction, la proportionnalité et la précaution sont les trois piliers du droit international humanitaire, ou lois de la guerre. Les forces armées doivent faire la distinction entre combattants et non-combattants, les victimes civiles et les dommages causés à des bâtiments civils ne doivent pas être excessifs par rapport aux gains militaires attendus, et toutes les parties doivent prendre les précautions nécessaires pour protéger les civils.

Tout ceci, clairement, requiert le jugement humain. Les robots n'ont pas la capacité d'analyser les intentions qui sous-tendent des actions, ni de prendre des décisions complexes concernant la proportionnalité ou la nécessité d'une attaque. Sans parler de la nécessité de faire preuve de compassion et d'empathie à l'égard des civils pris au piège de la guerre.

5. Les robots tueurs ne pourraient rendre des comptes, leurs commanditaires non plus

Si un robot agit en dehors de la loi, comment pourra-t-il être traduit en justice ? Les personnes l'ayant programmé, fabriqué et déployé, ainsi que les officiers supérieurs et les leaders politiques, pourraient être amenés à rendre des comptes. Cependant, ces personnes ne pouvant pas raisonnablement prévoir la réaction d'un robot tueur dans une circonstance donnée, cela créerait un déficit de responsabilisation.

Déjà, les investigations sur les homicides illégaux imputables à des frappes de drones sont rares, et personne ou presque n'est amené à rendre des comptes. Dans son rapport sur les frappes de drones américains au Pakistan, Amnesty International a dévoilé le secret entourant le programme d'assassinats ciblés par des drones mené par le gouvernement des États-Unis et son refus d'expliquer le fondement légal international de ces attaques individuelles, faisant craindre que les frappes dans les zones tribales pakistanaises n'aient bafoué les droits humains.

Garantir l'obligation de rendre des comptes pour les frappes réalisées par drones s'avère suffisamment ardu. Si l'on ajoute la strate supplémentaire qu'impliquerait l'usage de robots tueurs dans les décisions relatives à la cible et à sa suppression, il y aura très probablement une augmentation des blessures et homicides illégaux, à la fois sur le champ de bataille et durant les opérations de maintien de l'ordre.

[Avec] des robots tueurs [...] il y aura très probablement une augmentation des blessures et homicides illégaux, à la fois sur le champ de bataille et durant les opérations de maintien de l'ordre.

Rasha Abdul Rahim, Advocate/Adviser on Arms Control, Security Trade & Human Rights at Amnesty International

6. Le développement des robots tueurs = nouvelle course à l'armement.

La Chine, Israël, la Russie, la Corée du Sud, le Royaume-Uni et les États-Unis comptent parmi les États qui développent actuellement des systèmes permettant de rendre les machines plus autonomes au combat. Des entreprises dans plusieurs pays ont déjà développé des armes robotisées semi-autonomes, capables de projeter des gaz lacrymogènes, des balles en caoutchouc et des aiguillons à impulsions électriques lors des opérations de maintien de l'ordre.

Au regard de l'histoire du développement des armements, c'est une simple question de temps avant qu'une nouvelle course à l'armement de haute technologie ne soit lancée : les États s'efforceront de mettre au point et d'acquérir ces systèmes, déclenchant leur prolifération. Ces armes finiraient dans les arsenaux de gouvernements sans scrupules et, au final, entre les mains d'agents non gouvernementaux, notamment de groupes armés d'opposition et de gangs criminels.

7. Autoriser des machines à tuer : le franchissment d'une ligne morale fondamentale

Confier à des robots un pouvoir de décision dans des situations de vie ou de mort revient à franchir une ligne morale fondamentale. Ils n'éprouvent pas d'émotion, d'empathie ni de compassion, et leur usage irait à l'encontre des droits à la vie et à la dignité. Utiliser des machines pour tuer des hommes est la pire des ignominies.

8. Il sera impossible de stopper les robots tueurs

Comme le démontre la multiplication non contrôlée des drones, lorsque des systèmes d'armes sont employés, il est très difficile voire quasi impossible de réglementer ou de réfréner leur usage.

L'enquête « Drone Papers » récemment publiée par The Intercept, si elle est confirmée, dépeint un tableau alarmant du programme américain d'assassinats ciblés par des drones. Selon ces documents, sur une période de cinq mois, 90 % des victimes des frappes américaines réalisées par drones n'étaient pas les cibles désignées, ce qui souligne l'incapacité du gouvernement des États-Unis à garantir la transparence du programme des drones.

Il semble qu'il soit trop tard pour interdire l'utilisation de drones équipés d'armes, mais il convient de la restreindre à un seul usage : sauver des vies civiles. Les robots tueurs augmenteraient grandement le risque d'homicides illégaux. C'est pourquoi il faut les interdire à titre préventif. Adopter une approche « attentiste » pourrait déboucher sur une hausse de l'investissement dans le développement de ces systèmes d'armes et aboutir à leur prolifération rapide.

9. Des milliers d'experts en robotique demandent l'interdiction des robots tueurs.

En juillet 2015, des chercheurs, des scientifiques et des professionnels du monde de l'intelligence artificielle parmi les plus pointus ont signé une lettre ouverte pour demander l'interdiction totale des robots tueurs.

Elle a jusqu'à présent recueilli 2 587 signatures, dont celles de 14 présidents passés et actuels d'organisations et d'associations professionnelles du monde de l'intelligence artificielle et de la robotique. Parmi les illustres signataires figurent le directeur général de Google DeepMind Demis Hassabis, le PDG de Tesla Elon Musk, le cofondateur d'Apple Steve Wozniak, le cofondateur de Skype Jaan Tallin, et le professeur Stephen Hawking.

Si des milliers d'experts scientifiques et juridiques sont préoccupés par le développement et l'usage potentiel des robots tueurs et apportent leur soutien à la campagne Stop Killer Robots qui prône leur interdiction, qu'attendent donc les gouvernements ?

10. Depuis deux ans, beaucoup de débats, mais peu d'actes.

Depuis que les problèmes posés par les robots tueurs ont été mis en lumière en avril 2013, les seuls véritables débats internationaux sur cette question ont été deux réunions informelles d'experts d'une semaine à Genève dans le cadre de la conférence sur la Convention sur certaines armes classiques (CCAC). Si peu de temps pour un risque si grave, et si peu de progrès. Consternant.

Pour Amnesty International et ses partenaires de la campagne visant à stopper les robots tueurs, la seule solution est une interdiction totale du développement, du déploiement et de l'utilisation de systèmes d'armes létaux autonomes.

Le monde ne peut plus attendre pour agir contre cette menace. Il est temps de faire preuve de détermination et d'interdire définitivement les robots tueurs.

La thématique "contrôle des armes" vous intéresse ?

Inscrivez-vous à notre newsletter pour recevoir nos dernières informations sur le sujet