Le système algorithmique de Facebook a promu la haine contre les Rohingyas et a contribué ainsi aux atrocités commises par l’armée du Myanmar. Voici notre enquête.

Meta le savait, Meta n’a rien fait. Notre rapport « The social atrocity » démontre la responsabilité du géant américain dans les atrocités perpétrées contre le peuple rohingya à partir de 2017.

25 août 2017. Plus de 700 000 personnes fuyaient le Myanmar pour le Bangladesh pour échapper aux atrocités commises par les forces armées du Myanmar. Victimes d’une campagne de nettoyage ethnique, des milliers de Rohingyas ont été tués, torturés, des femmes violées.

Avant ces atrocités, les algorithmes de Facebook ont favorisé de manière proactive la diffusion de messages d’appels à la haine et à la violence contre les Rohingyas. La déshumanisation de cette communauté musulmane s’est normalisée dans tout le pays.

Conséquence : la haine virtuelle a contribué à la perpétration des violences dans la vie réelle.

Lire aussi : Le sort des Rohingyas au Myanmar

Notre enquête vient dénoncer le modèle économique de Facebook, basé sur la surveillance et le profit à tout prix, au point de mettre en danger toute une communauté. Meta doit verser des réparations aux Rohingyas et nous les soutenons dans leur demande de justice.

Sawyedollah, activiste et réfugié rohingyas de 21 ans a survécu aux atrocités de 2017 contre sa communauté. Téléphone connecté, son visage s’affiche à l’écran. Il s’adresse à nous depuis le camp de Cox’s Bazar, le plus grand camp de réfugiés au monde.

Bonjour du Bangladesh. Je vais vous parler de mon histoire et de mon peuple, victime d’un génocide commis par l’armée du Myanmar mais auquel Facebook a largement contribué.

Sawyedgollah, réfugié rohingya

Comment avons nous enquêté ?

Notre enquête s’appuie sur l’analyse de nouveaux documents provenant des «Facebook Papers» – documents internes rendus publics par la lanceuse d'alerte Frances Haugen. Nous avons mené des entretiens avec d’anciens membres du personnel de Facebook, avec des victimes rohyingyas ainsi qu’avec des experts de la société civile (militants des droits du numérique, universaitaires et avocats). Cette enquête reprend l’ensemble de nos recherches sur la campagne de nettoyage ethnique des Rohingyas de 2017.

Facebook et ses algorithmes amplificateurs de haine

« Nous déclarons ouvertement et catégoriquement que notre pays n'a pas de race Rohingya » : ce message a été publié sur Facebook par le général en chef de l’armée du Myanmar, Min Aung Hlaing. À ces messages du plus haut niveau de l’armée, s’ajoutent des centaines des messages de haine : « Les musulmans sont des chiens qui doivent être abattus », des messages d’incitation à la violence : « Ne le laissez pas vivre. Éliminez totalement sa race. Le temps presse. ». Voici le type messages qui circulaient au Myanmar, pays où « Facebook est internet » car la plateforme américaine y est omniprésente, et perçue par la population comme une source d’information fiable.

Pendant que l’armée du Myanmar commettait des crimes contre l’humanité contre les Rohingyas, Facebook tirait profit de la caisse de résonance créée par ses algorithmes conduisant à une hausse vertigineuse du sentiment de haine.

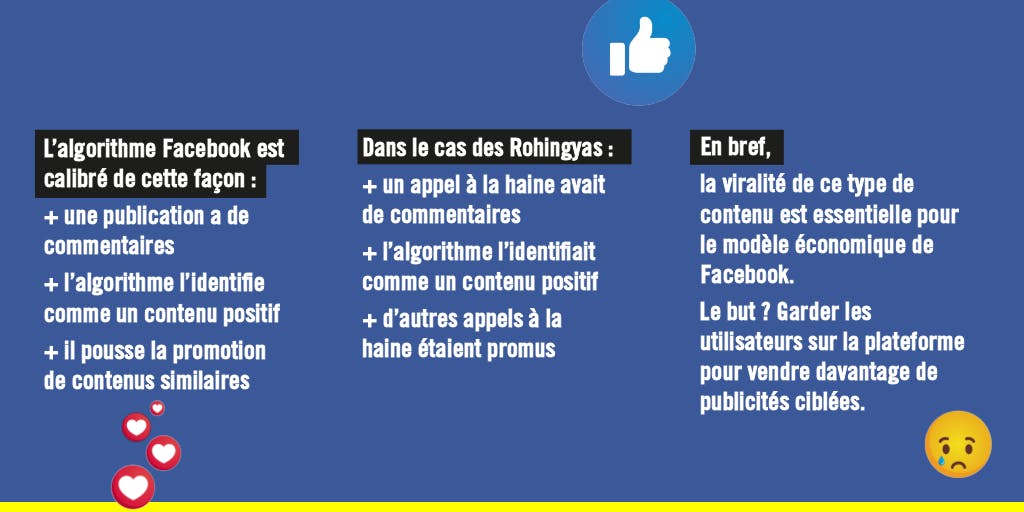

Mais comment ces messages ont-ils pu échapper à la modération de Facebook, pire encore, être favorisés sur la plateforme ? La réponse est dans ses algorithmes.

Les contenus les plus commentés, partagés, occupent une place privilégiée dans le fil d’actualités de Facebook. L’algorithme identifie le post comme suscitant de l’engagement et promeut sa diffusion et celle de contenus similaires. Problème : ces publications qui font réagir peuvent promouvoir des messages de haine. Ces systèmes donnent en réalité la priorité aux contenus les plus incendiaires, car plus susceptibles de «maximiser l'engagement». Les effets sont dévastateurs.

Lire aussi : Facebook et Google, les géants de la surveillance

Et la modération dans tout ça ?

Facebook a la capacité de modérer uniquement 2% des discours de haine qui circulent sur sa plateforme, qui rassemble aujourd’hui presque 3 milliards d’utilisateurs dans le monde. La modération peut réduire les discours de haine à une moindre échelle mais ne peut pas les contrôler. Elle ne maîtrise pas l’amplification des contenus haineux ou violents, permis par les algorithmes.

Des violences en ligne aux violences physiques

Juillet 2014. Mandalay, la deuxième plus grande ville du Myanmar. Une flambée de violence éclate entre des groupes bouddhistes et des groupes musulmans. Bilan humain : Deux morts, 14 blessés et plus de 300 personnes arrêtées. Le déclencheur de ces émeutes ? Un post Facebook qui affirmait, à tord, que des hommes musulmans avaient violé une jeune fille bouddhiste.

Si ce post Facebook a été aussi viral, au point de déclencher des émeutes, c’est parce que le système algorithmique l’a identifié comme « positif » au vu du nombre de commentaires et de partage. Cet exemple montre ce à quoi ont été confrontés les Rohingyas. Les messages de haine en ligne contre cette communauté ont contribué à normaliser les violences et à les encourager, dans le monde réel.

Katia Roux, notre chargée de plaidoyer spécialisée sur les sujets tech & droits humains revient en vidéo sur notre enquête. 👇

Le silence de Meta

Meta était tout à fait au courant des terribles conséquences que ses algorithmes pouvaient engendrer dans le monde réel. Pourtant, elle n'a rien fait. Notre enquête montre que l’entreprise américaine s’est abstenue, à plusieurs reprises, d’exercer la diligence requise en matière de droits humains pour ses opérations au Myanmar.

Lire aussi : Qu’est-ce que le devoir de vigilance ?

META voudrait nous faire croire que la plateforme est neutre. C’est faux.

META a directement amplifié la promotion des discours de haine et d’incitation à la violence, ce qui a indirectement ouvert la voie aux graves violations des droits humains commises contre les Rohingyas.

Patrick De Brun, spécialiste des nouvelles technologies à Amnesty International, chercheur du rapport “The social atrocity”

Dans le cadre de notre enquête, nous avons eu accès à de nouveaux documents des « Facebook Papers », jamais analysés jusque-là. Parmi eux, un document d’un salarié de Facebook, datant d’août 2019 dans lequel il affirme que le système de la plateforme encourage considérablement la propagation de discours de haine.

Les Royinghas demandent réparation

En 2022 des jeunes militants rohingyas du camp de Cox's Bazar au Bangladesh ont engagé contre Meta une procédure devant l'Organisation de coopération et de développement économiques (OCDE).

*La demande de financement ne représente que 0,002 % des bénéfices engrangés par Meta en 2021, qui se sont élevés à 46,7 milliards de dollars.

Ils souhaitent obtenir de l'entreprise des réparations via le financement à hauteur d’un million de dollars un projet d’enseignement dans le camp de réfugiés.* Demande rejetée par Meta qui a avancé le motif suivant : «Facebook ne participe pas directement à des activités philanthropiques.» Cette réponse montre la conception erronée que l’entreprise a de ses responsabilités en matière de droits humains.

Je ne savais pas comment m'attaquer à ce géant.

Sawyeddollah, jeune réfugié rohingya

La communauté rohingya ne demande pas la charité mais demande à Meta de verser des réparations pour les terribles préjudices qu’ils ont subis et auxquels l’entreprise a considérablement contribué.

Petit à petit, avec l’aide d’experts, le groupe de réfugiés rohingyas a engagé une procédure exigeant des réparations. David contre Goliath ? Meta pourrait en effet miser sur cette carte. C’est bien pour cela que nous devons nous tenir aux côtés des Rohingyas dans leur quête de justice, qui est une question de principe, mais également un besoin matériel urgent.

Le combat des Rohingyas pour obtenir réparation auprès de META nous concerne toutes et tous. Car si le fonctionnement de sa plateforme Facebook ne change pas, ce sont d’autres graves violations des droits humains qui pourront être commises.

Par cette enquête, nous souhaitons alerter sur le modèle économique de Meta : malgré le manque de reconnaissance de sa responsabilité concernant les contenus publiés sur ses plateformes, le respect des droits humains doit être au cœur du modèle de développement de ce géant du numérique. Nous pensons qu’une alternative est non seulement possible mais aussi primordiale afin d’empêcher que d’autres drames ne se reproduisent.